Dokument „Human at the Center: A Framework for Human-Driven AI Development” jasno pokazuje, że każdy system (niezależnie od jakości modelu) funkcjonuje w określonym kontekście:

- poznawczym,

- emocjonalnym

- społecznym użytkownika.

To właśnie ten kontekst decyduje o tym, czy AI realnie wspiera człowieka, czy stopniowo podkopuje jego sprawczość, kompetencje i zaufanie.

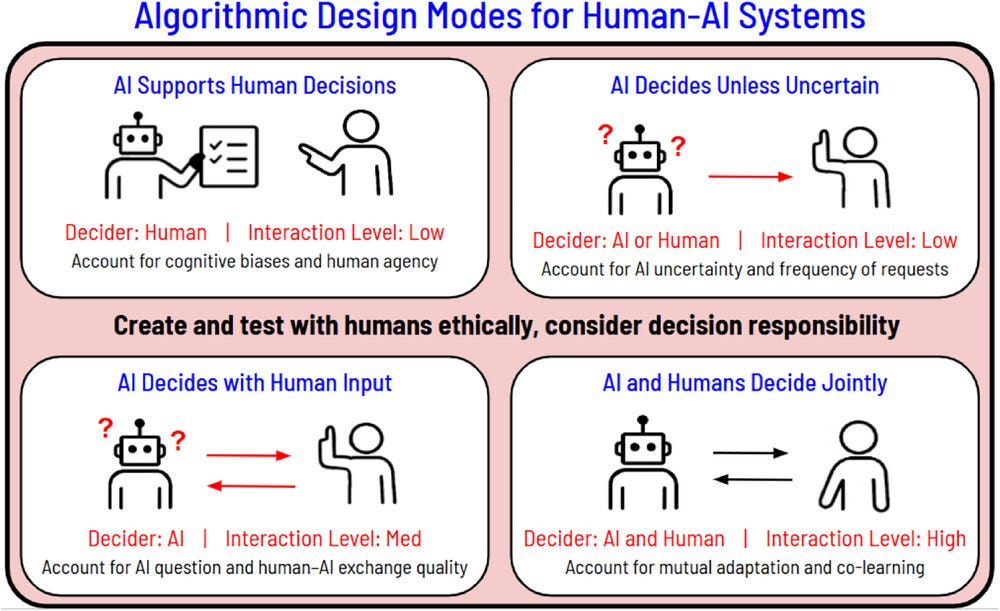

Cztery opisane tryby współpracy człowieka z AI nie są techniczną klasyfikacją. Są ramą projektową, która pozwala świadomie zaprojektować:

- podział odpowiedzialności,

- momenty kontroli i refleksji,

- sposób komunikowania niepewności,

- długofalowy wpływ produktu na zachowania użytkownika.

Każdy z tych trybów odpowiada na inne potrzeby, zakłada inny poziom autonomii systemu i inny zakres odpowiedzialności człowieka. Żaden z nich nie jest „lepszy” sam w sobie. Problemy zaczynają się wtedy, gdy tryb zostaje dobrany nieświadomie albo gdy interfejs komunikuje coś innego niż rzeczywisty podział odpowiedzialności.

“Human at the Center: A Framework for Human-Driven AI Development” Danniell Hu, Diana Acosta Navas, Susanne Gaube, Hussein Mozannar, Matthew E. Taylor, Krishnamurthy Dvijotham, Elizabeth Bondi-Kelly

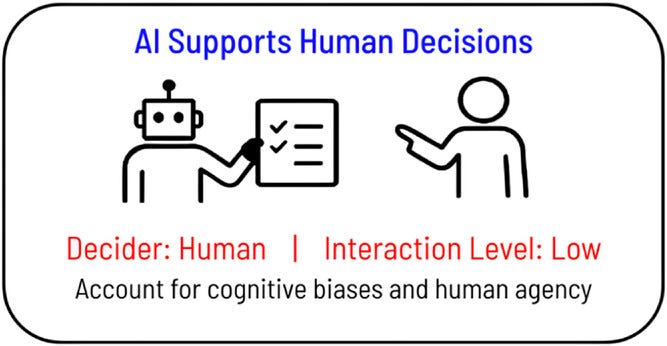

1. AI Supports Human Decisions

AI jako wsparcie, a nie zastępstwo decyzji

W tym trybie AI generuje predykcje, rekomendacje lub analizy, które mają pomóc człowiekowi w podjęciu decyzji, jednak odpowiedzialność za wybór końcowy pozostaje po stronie użytkownika. Jest to najczęściej spotykany model w produktach AI - od systemów rekomendacyjnych, przez narzędzia analityczne, po wsparcie kliniczne i finansowe.

Z perspektywy projektowej bywa on postrzegany jako „najbezpieczniejszy”, ponieważ formalnie nie odbiera człowiekowi kontroli. Badania przywoływane w dokumencie pokazują jednak, że formalna odpowiedzialność nie zawsze oznacza realną sprawczość.

“Human at the Center: A Framework for Human-Driven AI Development” Danniell Hu, Diana Acosta Navas, Susanne Gaube, Hussein Mozannar, Matthew E. Taylor, Krishnamurthy Dvijotham, Elizabeth Bondi-Kelly

Psychologia decyzji a rola rekomendacji

Użytkownicy rzadko traktują rekomendacje AI jako jedną z wielu równorzędnych informacji. W praktyce:

- rekomendacje są postrzegane jako bardziej „obiektywne”,

- liczby i wykresy budzą większe zaufanie niż intuicja,

- brak rekomendacji bywa odbierany jako brak wsparcia.

Prowadzi to do zjawiska automation bias, czyli skłonności do podążania za sugestią systemu nawet wtedy, gdy użytkownik ma wątpliwości lub wiedzę sprzeczną z rekomendacją. Z drugiej strony pojawia się algorithm aversion - po jednym wyraźnym błędzie użytkownicy zaczynają ignorować nawet poprawne sugestie.

Projektant produktu AI staje więc przed fundamentalnym pytaniem:

jak zaprojektować rekomendację, która wspiera myślenie, zamiast je zastępować?

Znaczenie formy, momentu i kontekstu

Nie tylko co AI komunikuje, ale jak i kiedy to robi, ma ogromne znaczenie. Wyjaśnienia:

- podane zbyt wcześnie mogą przeciążyć poznawczo,

- podane zbyt późno nie wpływają na decyzję,

- zbyt techniczne zwiększają dystans,

- zbyt uproszczone budują fałszywe poczucie pewności.

Dla projektantów oznacza to konieczność projektowania:

- momentów refleksji,

- wizualizacji niepewności,

- mechanizmów porównywania alternatyw,

- interfejsów, które aktywnie zachęcają do krytycznego myślenia.

W tym trybie AI nie powinna być „pewna siebie” w imieniu użytkownika. Jej rolą jest tworzenie warunków do lepszej decyzji, a nie sugerowanie jedynej słusznej odpowiedzi.

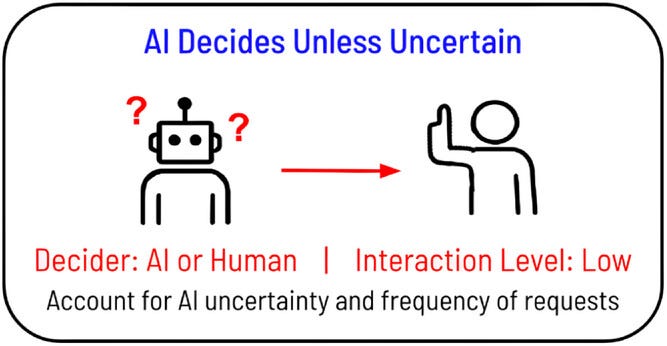

2. AI Decides Unless Uncertain

AI jako domyślny decydent z prawem do wycofania się

W drugim trybie AI działa samodzielnie w większości przypadków, podejmując decyzje automatycznie, ale rezygnuje z działania lub przekazuje sprawę człowiekowi w momencie wykrycia niepewności. Model ten jest często stosowany tam, gdzie liczy się skala, szybkość i powtarzalność, a koszt błędu jest wysoki.

Z pozoru jest to rozsądny kompromis: AI robi to, co potrafi najlepiej, a człowiek interweniuje w sytuacjach granicznych. W praktyce jednak generuje on poważne wyzwania projektowe.

“Human at the Center: A Framework for Human-Driven AI Development” Danniell Hu, Diana Acosta Navas, Susanne Gaube, Hussein Mozannar, Matthew E. Taylor, Krishnamurthy Dvijotham, Elizabeth Bondi-Kelly

Niepewność jako element doświadczenia użytkownika

Jednym z kluczowych problemów jest fakt, że niepewność AI nie jest intuicyjna dla ludzi. Użytkownicy często:

- nie rozumieją, dlaczego system nagle „oddaje decyzję”,

- interpretują to jako błąd lub brak kompetencji,

- nie są przygotowani do przejęcia odpowiedzialności.

Dokument pokazuje, że sposób komunikowania niepewności ma bezpośredni wpływ na jakość decyzji człowieka. Co istotne:

- samo poinformowanie o przekazaniu decyzji może poprawić trafność wyboru,

- pokazywanie predykcji AI w momencie deferral może tę trafność pogorszyć.

Z perspektywy projektowej oznacza to, że:

- nie zawsze warto ujawniać „co myślała AI”,

- czasem lepiej zakomunikować granice systemu niż jego wewnętrzne wnioski,

- to projekt interfejsu decyduje, czy użytkownik czuje się kompetentny, czy zagubiony.

Długofalowe skutki: erozja kompetencji

Autorzy dokumentu zwracają uwagę na jeszcze jeden istotny aspekt: długotrwałe korzystanie z systemów, które decydują za człowieka, prowadzi do stopniowej utraty umiejętności. Gdy AI przejmuje większość przypadków, użytkownik:

- rzadziej ćwiczy własny osąd,

- ma mniej okazji do uczenia się,

- w momentach przekazania decyzji bywa mniej skuteczny.

Dlatego projektanci muszą myśleć nie tylko o pojedynczym momencie interwencji, ale o trajektorii uczenia się użytkownika w czasie.

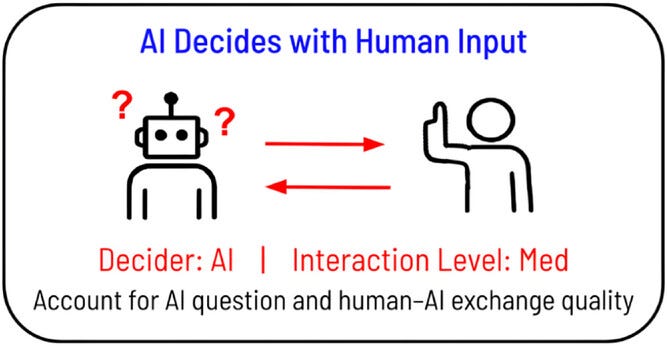

3. AI Decides with Human Input

Gdy AI wie, że potrzebuje człowieka

W trzecim trybie współpracy AI nie działa ani w pełni autonomicznie, ani wyłącznie jako pasywny doradca. Zamiast tego aktywnie rozpoznaje momenty niepewności i w tych momentach angażuje człowieka, prosząc o dodatkowe informacje, decyzje lub doprecyzowanie kontekstu.

Na pierwszy rzut oka jest to model bardzo „ludzki”. AI nie udaje wszechwiedzy – potrafi się zatrzymać i zapytać. W praktyce jest to jednak jeden z najbardziej wymagających trybów projektowych, ponieważ każda interakcja inicjowana przez system ma realny koszt poznawczy i decyzyjny.

“Human at the Center: A Framework for Human-Driven AI Development” Danniell Hu, Diana Acosta Navas, Susanne Gaube, Hussein Mozannar, Matthew E. Taylor, Krishnamurthy Dvijotham, Elizabeth Bondi-Kelly

Pytanie jako akt projektowy

Z perspektywy użytkownika pytanie zadane przez AI nigdy nie jest neutralne. Przerywa tok działania, wymaga interpretacji i zmusza do refleksji. Co więcej, użytkownik często nie wie:

- dlaczego to pytanie się pojawiło,

- co stanie się z jego odpowiedzią,

- jak duży wpływ będzie ona miała na wynik końcowy.

Jeżeli projektant nie zaprojektuje tego momentu świadomie, pytanie może:

- wprowadzać dezorientację,

- budować fałszywe poczucie odpowiedzialności,

- prowadzić do intuicyjnych lub losowych odpowiedzi, które pogarszają rezultat.

AI powinna pytać tylko wtedy, gdy odpowiedź człowieka realnie poprawia jakość decyzji. W przeciwnym razie interakcja staje się jedynie imitacją współpracy.

UX AI jako zarządzanie uwagą i energią poznawczą

W tym trybie szczególnie wyraźnie widać, że projektowanie AI nie polega na tworzeniu „rozmowy”, lecz na zarządzaniu uwagą, wysiłkiem poznawczym i motywacją użytkownika. Każde pytanie:

- konkuruje z innymi zadaniami,

- wymaga zrozumienia kontekstu,

- aktywuje heurystyki i skróty poznawcze.

Znajomość psychologii poznawczej i ekonomii behawioralnej staje się tu kluczowa. Użytkownicy:

- reagują inaczej w zależności od framingu pytania,

- często wybierają opcje domyślne,

- unikają odpowiedzi wymagających dużego wysiłku.

Dobrze zaprojektowany pattern UX AI:

- jasno komunikuje, dlaczego pytanie się pojawia,

- ogranicza liczbę odpowiedzi do sensownego minimum,

- pokazuje użytkownikowi, że jego wkład ma realne znaczenie.

W przeciwnym razie AI zaczyna być postrzegana jako system, który przeszkadza, a nie wspiera proces decyzyjny.

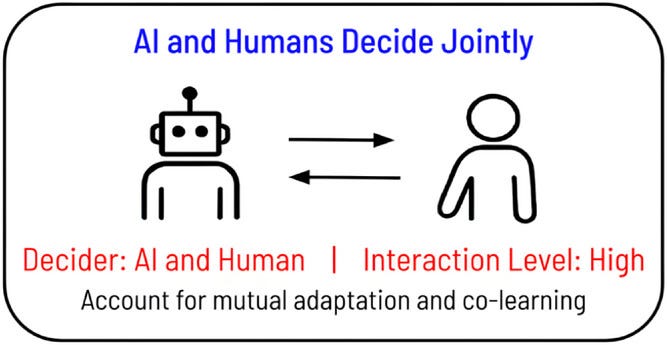

4. AI and Humans Decide Jointly

Gdy współpraca staje się procesem, a nie interakcją

Czwarty tryb to najbardziej zaawansowana i najbardziej subtelna forma współpracy człowieka z AI. W tym modelu:

- człowiek i AI działają równolegle,

- inicjatywa przechodzi dynamicznie z jednej strony na drugą,

- obie strony uczą się siebie w czasie.

Nie jest to już wsparcie decyzji ani delegowanie zadań, lecz ciągły proces współtworzenia, charakterystyczny dla narzędzi kreatywnych, systemów programistycznych i zaawansowanych asystentów pracy intelektualnej.

“Human at the Center: A Framework for Human-Driven AI Development” Danniell Hu, Diana Acosta Navas, Susanne Gaube, Hussein Mozannar, Matthew E. Taylor, Krishnamurthy Dvijotham, Elizabeth Bondi-Kelly

Mentalny model AI po stronie użytkownika

Największym wyzwaniem projektowym w tym trybie jest konieczność stopniowego budowania mentalnego modelu działania AI po stronie użytkownika. Musi on rozumieć:

- w jakich sytuacjach AI przejmuje inicjatywę,

- kiedy warto ją korygować,

- czego można się po niej spodziewać.

Nie da się tego osiągnąć jednorazowym onboardingiem ani tooltipem. Mentalny model powstaje poprzez:

- powtarzalne zachowania systemu,

- spójne reakcje na podobne sytuacje,

- czytelne sygnały niepewności i granic.

To właśnie tutaj projektowanie interfejsu i patternów UX AI nabiera kluczowego znaczenia. Interfejs staje się medium relacji, a nie tylko nośnikiem funkcji.

Ryzyko nadmiernej personalizacji i „cichej manipulacji”

Wspólna adaptacja niesie również istotne ryzyko. Systemy uczące się użytkownika w czasie mogą:

- wzmacniać istniejące przekonania,

- zawężać pole eksploracji,

- prowadzić do coraz mniej refleksyjnych decyzji.

Z perspektywy ekonomii behawioralnej jest to szczególnie niebezpieczne. AI może nieintencjonalnie:

- ograniczać ekspozycję na alternatywy,

- wzmacniać efekt potwierdzenia,

- przesuwać wybory w stronę opcji najwygodniejszych, a nie najlepszych.

Dlatego w tym trybie projektant nie projektuje już wyłącznie użyteczności, lecz architekturę wyboru. Każdy default, każda sugestia i każda kolejność opcji ma znaczenie.

Dobrze zaprojektowana współpraca człowieka z AI:

- pozostawia przestrzeń na sprzeciw,

- umożliwia refleksję,

- nie ukrywa niepewności pod pozorem płynnego UX.

Projektowanie AI to projektowanie zachowań

Analiza czterech trybów współpracy prowadzi do jednego wniosku: AI zawsze wpływa na ludzkie zachowania, tylko pytanie czy robimy to “świadomie”.

Projektanci produktów AI muszą dziś łączyć:

- projektowanie interfejsów i znajomość dobrych patternów UX AI,

- rozumienie psychologii decyzji,

- podstawy ekonomii behawioralnej,

- świadomość regulacyjną i etyczną.

Bez tego nawet najlepiej działający model może prowadzić do utraty zaufania, chaosu w doświadczeniu użytkownika oraz realnych ryzyk reputacyjnych i prawnych.

BehaviorAI odpowiada na tę lukę, oferując produktowe podejście do odpowiedzialnego projektowania AI. Tworzymy bibliotekę wzorców projektowych osadzonych w kontekście zachowań, psychologii i doświadczeń użytkowników, zaprojektowana z myślą o codziennych decyzjach zespołów produktowych.

Jej celem nie jest sama inspiracja, lecz dostarczanie praktycznych narzędzi, które pomagają unikać manipulacyjnych wzorców, porządkować UX AI i budować trwałe zaufanie do produktów opartych na sztucznej inteligencji.

.png)